Качество средств и результатов измерений принято характеризовать, указывая их погрешности. Введение понятия "погрешность" требует определения и чёткого разграничения трёх понятий: истинного и действительного значений измеряемой физической величины и результата измерения.

Истинное значение хи физической величины - это значение, идеальным образом отражающее свойство данного объекта как в количественном, так и в качественном отношении. Оно не зависит от средств нашего познания и является той абсолютной истиной, к которой мы стремимся, пытаясь выразить её в виде числовых значений. На практике истинное значение практически всегда неизвестно (в редких случаях оно может быть определено с применением первичных или вторичных эталонов), поэтому его приходится заменять понятием "действительное значение".

Действительное значение хд физической величины - значение, найденное экспериментально и настолько приближающееся к истинному, что для данной цели оно может быть использовано вместо него. Действительное значение может быть получено при помощи рабочих эталонов.

Результат измерения (измеренное значение) х представляет собой приближённую оценку истинного значения величины, найденную путём измерения (результат, полученный с помощью рабочего средства измерения).

Понятие "погрешность" - одно из центральных в метрологии, где используются понятия "погрешность результата измерения" и "погрешность средства измерения".

Погрешность результата измерения - это отклонение результата измерения от истинного значения измеряемой величины.

Погрешность средства измерения - отклонение показания средства измерения от истинного (действительного) значения измеряемой величины. Оно характеризует точность результатов измерений, проводимых данным средством.

Эти два понятия во многом близки друг к другу и классифицируются по одинаковым признакам.

По способу выражения различают: абсолютные, относительные и приведённые погрешности.

Абсолютная погрешность Δх выражается в единицах измеряемой величины х и равна разности между измеренным и истинным значениями (так как истинное значение практически всегда бывает неизвестно, то вместо него может использоваться действительное значение):

![]()

Абсолютная погрешность не может в полной мере служить показателем точности измерений, так как одно и то же её значение, например, Δх = 0,5 мм при х= 100 мм соответствует достаточно высокой точности измерений, а при х= 1 мм - низкой. Поэтому и вводится понятие относительной погрешности.

Относительная погрешность δx представляет собой отношение абсолютной погрешности измерения к истинному (действительному, измеренному) значению и часто выражается в процентах:

Эти формулы справедливы при условии, что .

![]()

Эта наглядная характеристика точности результата измерения не годится для нормирования погрешности средства измерения, так как при изменении значений хи принимает различные значения вплоть до бесконечности при хи = 0. В связи с этим для указания и нормирования погрешностей средств измерений используется ещё одна разновидность погрешности - приведённая.

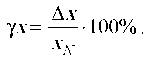

Приведённая погрешность γx представляет собой отношение абсолютной погрешности средства измерения к так называемому нормирующему значению xN (постоянному во всем диапазоне измерений или его части), обычно выражается в процентах:

Нормирующее значение xN определяется различным образом в зависимости от шкалы прибора.

Для приборов, шкала которых содержит нулевую отметку, в качестве нормирующего значения принимают размах шкалы прибора.

Например, если прибор имеет шкалу от 0 до 1000 единиц, то xN = |1000 - 0 = 1000 ед.; если прибор имеет шкалу от -30 до 70 единиц, то xN = |70 - (-30) = 100 ед.

Для приборов, шкала которых не имеет нулевой отметки, в качестве нормирующего значения принимают максимальное по абсолютной величине значение шкалы:

![]()

Например, если прибор имеет шкалу от 900 до 1000 единиц, то xN = 1000 ед.; если прибор имеет шкалу от -300 до -200 единиц, то xN = 300 ед.

Понятие о вариации показаний приборов. Абсолютная вариация показаний прибора ε - разность между показаниями прибора при многократных повторных измерениях одной и той же физической величины.

На практике вариацию показаний прибора определяют, как разность показаний прибора в одной и той же точке диапазона измерений при плавном подходе к ней сначала со стороны меньших, а затем со стороны больших значений измеряемой величины:

![]()

Значения Х прямого хода получают при увеличении измеряемого параметра, значения Х обратного хода - при уменьшении измеряемого параметра.

Абсолютная вариация показаний прибора обусловлена наличием эффектов гистерезиса и является частью абсолютной погрешности прибора.

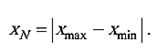

Относительная вариация показаний прибора δε - отношение абсолютной вариации к истинному (действительному, измеренному) значению измеряемой величины, обычно выражается в процентах:

Приведённая вариация показания прибора γε - отношение абсолютной вариации к нормирующему значению, обычно выражается в процентах:

![]()

По характеру проявления погрешности делятся на случайные, систематические и грубые (промахи).

Систематическая погрешность - составляющая погрешности измерения, остающаяся постоянной или закономерно изменяющаяся при повторных измерениях одной и той же физической величины. Систематические погрешности могут быть предсказаны, обнаружены и, благодаря этому, почти полностью устранены введением соответствующей поправки или регулировкой средства измерения.

Случайная погрешность - составляющая погрешности измерения, изменяющаяся случайным образом (по знаку и значению) в серии повторных измерений одного и того же значения физической величины, проведённых с одинаковой тщательностью в одних и тех же условиях. В появлении таких погрешностей не наблюдается какой-либо закономерности, они обнаруживаются при повторных измерениях одной и той же величины в виде некоторого разброса получаемых результатов. Случайные погрешности неизбежны, неустранимы и всегда присутствуют в результате измерения. Описание случайных погрешностей возможно только на основе теории случайных процессов и математической статистики. В отличие от систематических, случайные погрешности нельзя исключить из результатов измерений путём введения поправки, однако их можно существенно уменьшить путём увеличения числа наблюдений и их статистической обработки. Поэтому для получения результата, минимально отличающегося от истинного значения измеряемой величины, проводят многократные измерения физической величины с последующей математической обработкой экспериментальных данных.

Грубая погрешность (промах) - это случайная погрешность результата отдельного наблюдения, входящего в ряд измерений, которая для данных условий резко отличается от остальных результатов этого ряда. Они, как правило, возникают из-за ошибок или неправильных действий оператора (его психофизиологического состояния, неверного отсчёта, считывания показаний с соседней шкалы прибора, ошибок в записях или вычислениях, неправильного включения приборов или сбоев в их работе и др.). Возможной причиной возникновения промахов также могут быть кратковременные резкие изменения условий проведения измерений. Если промахи обнаруживаются в процессе измерений, то результаты, их содержащие, отбрасывают. Однако чаще всего промахи выявляют только при окончательной обработке результатов измерений с помощью специальных статистических критериев.

В зависимости от причин возникновения различают инструментальные, методические и субъективные погрешности.

Инструментальная погрешность - погрешность, присущая самому средству измерений, т.е. тому прибору или преобразователю, при помощи которого выполняется измерение. Причинами инструментальной погрешности могут быть несовершенство конструкции средства измерений, влияние окружающей среды на его характеристики, деформация или износ деталей прибора и т.п.

Методическая погрешность появляется вследствие несовершенства метода измерения; несоответствия измеряемой величины и её модели, принятой при разработке средства измерения; влияния средства измерений на объект измерения и процессы, происходящие в нём. Отличительной особенностей методических погрешностей является то, что они не могут быть указаны в нормативно-технической документации на средство измерения, поскольку от него не зависят, а должны определяться оператором в каждом конкретном случае.

Субъективная (личная) погрешность измерения обусловлена погрешностью отсчёта оператором показания по шкалам средства измерений, диаграммам регистрирующих приборов. Они вызываются состоянием оператора, его положением во время работы, несовершенством органов чувств, эргономическими свойствами средства измерений. Характеристики субъективной погрешности определяют на основе нормированной номинальной цены деления шкалы измерительного прибора (или диаграммной бумаги регистрирующего прибора) с учётом способностей "среднего оператора" к интерполяции в пределах деления шкалы. Эти погрешности уменьшаются по мере совершенствования приборов, например, применение светового указателя в аналоговых приборах устраняет погрешность вследствие параллакса, применение цифрового отсчёта исключает субъективную погрешность.

Объективная погрешность измерения - погрешность, не зависящая от личных качеств человека, производящего измерение.

По влиянию внешних условий различают основную и дополнительную погрешности средства измерений.

Основной называется погрешность средства измерений, определяемая в нормальных условиях его применения. Для каждого средства измерений в нормативно-технических документах оговариваются условия эксплуатации - совокупность влияющих величин (температура окружающей среды, влажность, давление, напряжение, частота питающей сети и др.), при которых нормируется его погрешность (влияющая величина - это физическая величина, не измеряемая данным средством измерений, но оказывающая влияние на его результаты).

Дополнительной называется погрешность средства измерений, возникающая вследствие отклонения какой-либо из влияющих величин, т.е. дополнительная погрешность, увеличивающая общую погрешность прибора, возникает, если прибор работает в условиях, отличных от нормальных.

В зависимости от характера изменения величины погрешности при изменении измеряемой величины погрешности делятся на аддитивные и мультипликативные.

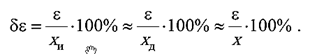

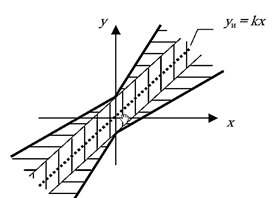

Аддитивные погрешности обусловлены смещением статической характеристики прибора вверх или вниз (вправо или влево), например, из-за смещения шкалы прибора (дрейфа нуля), трения в опорах и т.д. Аддитивная погрешность не зависит от значения измеряемой величины х, т.е. постоянна по всей шкале прибора.

Влияние аддитивных погрешностей на статическую характеристику прибора показано на рис. 1.6.

Аддитивная погрешность (при выражении её в виде абсолютной погрешности) имеет постоянную величину, не зависящую от значения измеряемой величины х.

![]()

Аддитивные погрешности преобладают у большинства аналоговых приборов.

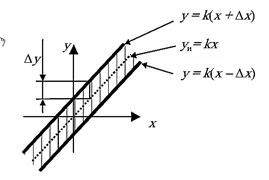

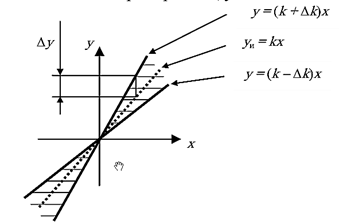

Мультипликативные погрешности возникают из-за погрешностей задания передаточного коэффициента к статической характеристики y= kx. Мультипликативная погрешность зависит от значения измеряемой величины и увеличивается к концу шкалы прибора.

![]()

Влияние мультипликативных погрешностей на статическую характеристику прибора показано на рис. 1.7. Мультипликативная погрешность (при выражении её в виде абсолютной погрешности) пропорциональна значению измеряемой величины.

Рис. 1.6. Влияние аддитивных погрешностей на статическую характеристику прибора: уи - идеальная статическая характеристика; у - фактическая статическая характеристика

Рис. 1.7. Влияние мультипликативных погрешностей на статическую характеристику прибора: уи - идеальная статическая характеристика; у - фактическая статическая характеристика

Мультипликативные погрешности преобладают у приборов, относящихся к масштабирующим преобразователям (шунты, добавочные сопротивления, усилители, делители, трансформаторы и т.п.).

Существуют приборы, у которых аддитивные и мультипликативные погрешности соизмеримы. К этому классу приборов относятся цифровые приборы. Влияние соизмеримых аддитивных и мультипликативных погрешностей на статическую характеристику прибора показано на рис. 1.8.

Рис. 1.8. Влияние соизмеримых аддитивных и мультипликативных погрешностей на статическую характеристику прибора: уи - идеальная статическая характеристика; аддитивная составляющая погрешности; мультипликативная составляющая погрешности

Класс точности - это обобщённая характеристика средства измерений, выражаемая пределами допускаемых значений его основной и дополнительной погрешностей, а также другими характеристиками, влияющими на точность. Класс точности не является непосредственной оценкой точности измерений, выполняемых этим средством измерений, поскольку погрешность зависит ещё от ряда факторов: метода измерений, условий измерений и т.д. Класс точности лишь позволяет судить о том, в каких пределах находится погрешность средства измерений данного типа.

Государственными стандартами для разных приборов установлены различные классы точности, которые обычно указывают на шкале или корпусе прибора. Средство измерений может иметь два и более класса точности. Например, при наличии у него двух или более диапазонов измерений одной и той же физической величины ему можно присваивать два или более класса точности. Приборы, предназначенные для измерений нескольких физических величин, также могут иметь различные классы точности для каждой измеряемой величины.

Существует несколько способов задания классов точности приборов:

- 1-й способ используется для мер. При этом способе указывается порядковый номер класса точности меры. Например, нормальный элемент 1 класса точности, набор разновесов (гирь) 2 класса точности и т.п. Порядок вычисления погрешностей в этом случае определяют по технической документации, прилагаемой к мере.

- 2-й способ предусматривает задание класса точности для приборов с преобладающими аддитивными погрешностями. В этом случае класс точности задаётся в виде числа К (без кружочка). При этом нормируется основная приведённая погрешность γх прибора, выраженная в процентах, которая во всех точках шкалы не должна превышать по модулю числа К, т.е. |γх| < К, %.

Число К выбирается из ряда значений (1,0; 1,5; 2; 2,5; 4,0; 5,0; 6,0)-10n, где n = 1, 0, -1, -2, ... .

3-й способ предусматривает задание класса точности для приборов с преобладающими мультипликативными погрешностями. В этом случае нормируется основная относительная погрешность, выраженная в процентах, так что | δX | ≤ К, %. Класс точности задаётся в виде числа К в кружочке .

Число К выбирается из приведённого выше ряда.

- 4-й способ предусматривает задание класса точности для приборов с соизмеримыми аддитивными и мультипликативными погрешностями.

В этом случае класс точности задаётся двумя числами a/b, разделёнными косой чертой, причём a > b. При этом нормируется основная относительная погрешность, вычисляемая по формуле:

![]()

где X -максимальное конечное значение пределов измерений. Число a отвечает за мультипликативную составляющую погрешности, а число b - за аддитивную составляющую погрешности. Значения, а и b выбираются из вышеприведённого ряда.

- 5-й способ задания класса точности используется для приборов с резко неравномерной шкалой. Класс точности задаётся К числом К, подчёркнутым галочкой . В этом случае нормируется основная приведённая погрешность в процентах от длины шкалы.

Поверка средств измерений (поверка) - установление органом государственной метрологической службы (или другим официально уполномоченным органом, организацией) пригодности средства измерений к применению на основании экспериментально определяемых метрологических характеристик и подтверждения их соответствия установленным обязательным требованиям.

Поверка средств измерений - совокупность операций, выполняемых в целях подтверждения соответствия средств измерений метрологическим требованиям [2].

Поверке подвергают средства измерений, подлежащие государственному метрологическому контролю и надзору.

При поверке используют рабочий эталон. Поверку проводят в соответствии с обязательными требованиями, установленными нормативными документами по поверке. Поверку проводят специально обученные специалисты, аттестованные в качестве поверителей органами Государственной метрологической службы.

Существуют следующие виды поверок.

Первичная - поверка, выполняемая при выпуске средства измерений из производства или после ремонта, а также при ввозе СИ из-за границы партиями, при продаже.

Периодическая - поверка СИ, находящихся в эксплуатации или на хранении, выполняемая через установленные межповерочные интервалы времени (обычно 1, 2 или 0,5 года).

Внеочередная - поверка СИ, проводимая до наступления срока его очередной периодической поверки. Необходимость внеочередной поверки может возникнуть из-за ухудшения метрологических свойств СИ или подозрения в этом, нарушения условий эксплуатации и др.

Выборочная - поверка группы СИ, отобранных из партии случайным образом, по результатам которой судят о пригодности к эксплуатации всей партии.

Инспекционная - поверка СИ, проводимая органом Государственной метрологической службы при проведении государственного надзора за состоянием и применением СИ.

Поверка средств измерений (приборов) включает в себя следующие операции:

Определение исправности прибора и наличия комплектующих.

1. Для этого проводят внешний осмотр прибора, проверяют наличие паспорта, технической документации, комплектующих изделий, проверяют наличие маркировки и табличек (шильдиков) с указанием марки прибора, года изготовления, завода-изготовителя, заводского номера прибора и т. д. Проверяют отсутствие внешних повреждений, отсутствие подтёков масла и т.п. При наличии хотя бы одного из перечисленных недостатков прибор считается не прошедшим поверку.

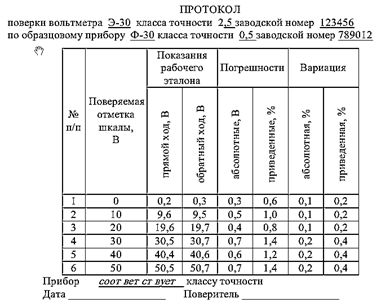

2. После предварительного осмотра прибор подвергают собственно поверке. Целью операции поверки является проверка соответствия прибора его классу точности.

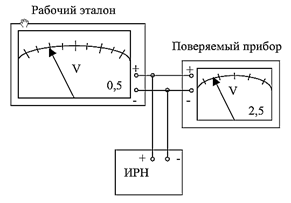

1) При поверке сличают показания поверяемого прибора с показаниями рабочего эталона по утверждённой схеме. Например, при поверке вольтметра эта схема может иметь вид, представленный на рис. 1.9.

2) Класс точности рабочего эталона должен быть выше класса точности поверяемого прибора не менее, чем в 5 раз. Допускается использовать рабочий эталон с классом точности в 3 раза выше класса точности поверяемого прибора при условии введения поправок в показания рабочего эталона.

3) Поверяют все оцифрованные отметки шкалы поверяемого прибора.

Рис.1.9. схема поверки вольтметра; ИРН - источник регулируемого напряжения; 5 - класс точности рабочего эталона; 2,5 - класс точности поверяемого прибора

4) С целью выявления вариации показаний поверяемого прибора, поверку ведут при прямом ходе стрелки (при возрастании показаний) и при обратном ходе стрелки (при уменьшении показаний). Если при прямом ходе стрелка заскочила за поверяемую отметку, то её надо вернуть обратно и вновь плавно подвести к поверяемой отметке.

3. В протокол после поверки заносят рассчитанные значения погрешностей измерений и вариации показаний (в качестве абсолютной погрешности принимают максимальное из двух значений абсолютной погрешности, полученных при прямом и обратном ходе). В нижней части протокола (под таблицей) делается запись о соответствии прибора классу точности.

Прибор прошёл поверку и признан годным, если:

1) его основная приведённая (относительная) погрешность не превышает класса точности;

2) приведённая (относительная) вариация показаний не превышает % класса точности для приборов, класс точности которых больше чем 0,25;

3) приведённая (относительная) вариация показаний не превышает 0,2% для приборов, класс точности которых 0,25 и меньше.

Рис. 1.10. Пример протокола поверки вольтметра

Протокол подписывается лицом, выполнившим поверку. В паспорте прибора делается отметка, что прибор прошёл поверку, и ставится клеймо поверителя. Это же клеймо ставится на корпусе прибора.